Introduzione

Il campo dell'intelligenza artificiale sta vivendo un periodo di grande fermento grazie allo sviluppo di agenti autonomi in grado di eseguire compiti complessi in ambienti diversi. Questi agenti sono progettati per interpretare e attuare istruzioni in linguaggio naturale all'interno di interfacce grafiche, come siti web, sistemi operativi desktop e dispositivi mobili. La loro capacità di navigare e svolgere attività in modo fluido in vari contesti è fondamentale per migliorare l'interazione uomo-macchina, consentendo ai computer di gestire funzioni sempre più intricate su più piattaforme.

La Sfida dei Benchmark Tradizionali

Uno dei principali ostacoli nello sviluppo di questi agenti è la creazione di benchmark affidabili che possano valutare con precisione le loro prestazioni in scenari reali. I benchmark tradizionali spesso non soddisfano questa esigenza, presentando limitazioni come un focus ristretto su compiti in ambienti singoli, dipendenza da dataset statici e metodi di valutazione semplicistici che non riflettono la natura dinamica delle applicazioni reali. Ad esempio, i benchmark esistenti valutano gli agenti in base al raggiungimento di un obiettivo finale, senza considerare i progressi incrementali durante il compito o i molteplici approcci validi che un agente potrebbe adottare. Questo porta a una valutazione meno completa che potrebbe non catturare accuratamente le capacità dell'agente.

Il Framework Crab: Innovazione nei Benchmark

Un gruppo di ricercatori provenienti da istituzioni prestigiose come KAUST, Eigent.AI, UTokyo, CMU, Stanford, Harvard, Tsinghua, SUSTech e Oxford ha sviluppato il Crab framework, uno strumento di benchmarking innovativo progettato per valutare compiti trasversali tra ambienti. Questo framework si distingue per la sua capacità di supportare funzioni che si estendono su più dispositivi e piattaforme, come desktop e telefoni mobili, e per l'integrazione di un metodo di valutazione basato su grafi che offre un'analisi più dettagliata delle prestazioni degli agenti.

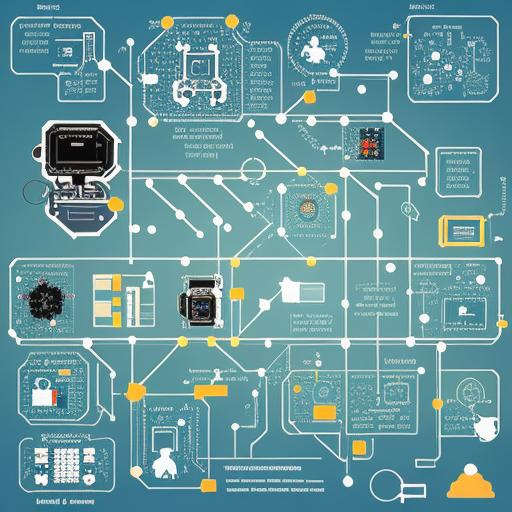

Struttura e Funzionalità del Crab Framework

Il Crab framework introduce un approccio innovativo alla valutazione dei compiti, decomponendo le attività complesse in sotto-compiti più gestibili, ciascuno rappresentato come nodi in un grafo aciclico diretto (DAG). Questa struttura grafica consente l'esecuzione sequenziale e parallela dei sotto-compiti, valutati in più punti anziché solo alla fine. Questo metodo permette di valutare le prestazioni di un agente in ogni fase del compito, offrendo una visione più accurata di come l'agente funzioni in diversi ambienti. La flessibilità di questo approccio consente anche di considerare molteplici percorsi validi per completare un compito, garantendo una valutazione più equa e completa.

Implementazione del Crab Benchmark-v0

Nel Crab Benchmark-v0, i ricercatori hanno implementato un insieme di 100 compiti reali che coprono sia sfide trasversali tra ambienti che in ambienti singoli. Questi compiti sono progettati per riflettere applicazioni comuni, come la gestione di calendari, l'invio di email, la navigazione su mappe e l'interazione con browser web e comandi terminali. Il benchmark include 29 compiti per dispositivi Android, 53 per desktop Ubuntu e 18 compiti che richiedono interazione tra entrambi gli ambienti. Questo set completo di funzioni consente una valutazione rigorosa delle capacità degli agenti di operare su diverse piattaforme, simulando le condizioni reali il più possibile.

Risultati e Analisi delle Prestazioni

Il team di ricerca ha testato il framework Crab utilizzando quattro modelli di linguaggio multimodali avanzati (MLM): GPT-4o, GPT-4 Turbo, Claude 3 Opus e Gemini 1.5 Pro. Gli agenti sono stati valutati in configurazioni a singolo e multi-agente, con nove diverse impostazioni testate. I risultati hanno rivelato che la configurazione a singolo agente utilizzando il modello GPT-4o ha raggiunto il più alto tasso di completamento dei compiti, pari al 35,26%, evidenziando la sua superiore capacità di gestire compiti trasversali. Al contrario, altri modelli e configurazioni hanno mostrato efficacia variabile, con le strutture multi-agente generalmente meno performanti rispetto a quelle a singolo agente. Le metriche di prestazione introdotte dal Crab framework, come il Completion Ratio (CR), Execution Efficiency (EE) e Cost Efficiency (CE), hanno distinto con successo i metodi, evidenziando i punti di forza e di debolezza di ciascun modello.

Conclusioni e Prospettive Future

Il framework Crab offre un metodo di valutazione dettagliato basato su grafi e supporta compiti trasversali, fornendo una valutazione più dinamica e accurata delle prestazioni degli agenti. I rigorosi test del benchmark con MLM avanzati come GPT-4o e GPT-4 Turbo hanno fornito preziose intuizioni sulle capacità e le sfide degli attuali agenti autonomi, aprendo la strada a future ricerche e sviluppi in questo campo. La capacità del framework di rispecchiare fedelmente le condizioni reali lo rende uno strumento cruciale per il progresso della ricerca sugli agenti autonomi.